ඩීප්ෆෙක් තාක්ෂණයෙන් සේවකයකු රවටා ඩොලර් මිලියන 25ක් හොරකම් කරලා

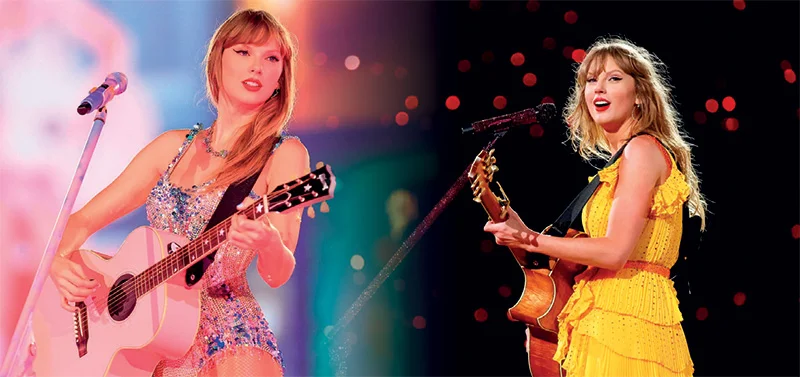

පසුගිය වසරේ ජනවාරි අග භාගය ගෙවී ගියේ මුළු ලෝකයටම රස කර කර තළු මරන්නට මාතෘකාවක් ඉතිරි කරමිනි. තළු මැරූ මාතෘකාව ලෝක ප්රකට අමෙරිකානු පොප් ගායිකා ටේලර් ස්විෆ්ට්ය. අඟ පසඟ පෙනෙන්නට ඇඳුම් ආයිත්තම් ඇන්ද ද කෙදිනකවත් සිය නිරුවත නොපෙන්නූ සුරූපී ටේලර් ස්විෆ්ට්ගේ නිරුවත් ඡායාරූප රැසක් සමාජ මාධ්ය කිහිපයකම එක්තරා උදෑසනක ප්රදර්ශනය වෙමින් තිබුණි. යළි කෙදිනකවත් දැකගැනීමට නොලැබෙනා ටේලර්ගේ වටිනා නිරුවත සොයා සමාජ මාධ්ය පරිශීලකයන් මිලියන ගණනින් ඉන්ස්ටර්ග්රෑම්, ට්විටර් සහ වෙබ් අඩවි පීරන්නට විය. අසභ්ය ලෙස ඡායාරූපවලට පෙනී සිටීම සම්බන්ධයෙන් ඇය එම කාලවකවානුවේ මහජනතාවගෙන් පමණක් නොව ජනාධිපති මන්දිරයෙන් පවා දැඩි දෝෂ දර්ශනයට ලක්විය. එයට හේතුව ඇසින් දුටුවත්, කනින් ඇසුවත් අතට හසුවන තෙක් බලා සිටින්නට ඉවසීමක් නොමැත්තෝ තමන්ගේ දෑස් මානයේ දර්ශනය වන දේ ඉහටත් උඩින් විශ්වාස කිරීමට පෙළඹුණ නිසාය. අද කියා ද එහි වෙනසක් නැත.

ටේලර්ගේ මෙම ආන්දෝලනාත්මක සිදුවීම ඔස්සේ ලොව පුරා බොහෝදෙනකුට කනට නුහුරුව තිබූ වචනයක් හුරු වන්නට විය. ඒ ‘ඩීප් ෆේක්ස්’ ය. නිරුවත් ඡායාරූප ලෙස සමාජ ජාලා හා සමාජ මාධ්ය තුළ සංසරණය වූ ටේලර් ස්විෆ්ට්ගේ ඡායාරූප ද ඩීප් ෆේක්ස් ආශ්රයෙන් නිර්මාණය වූ ව්යාජ ඡායාරූප බව පසුව හෙළි විය. මෙම සිදුවීමත් සමග ඇගේ සියලුම ඡායාරූප සමාජ ජාලා තුළින් ඉවත් කරන්නට පියවර ගැනිණි. කෙසේ වෙතත් ඉවත් කිරීමට පෙර එක් ඡායාරූපයක් මිලියන 50කට ආසන්න සංඛ්යාවක් නරඹා තිබුණි. ටේලර්ගේ මෙම සිදුවීම තාක්ෂණික මෙවලම් කොයිතාක් දුරකට පුද්ගලයකුට තර්ජනයක් විය හැකිද යන්න ලොවට හොඳින්ම පැහැදිලි කළ උදාහරණයක් විය. ඊට ඇයගේ අතිශය ප්රසිද්ධිය ද බෙහෙවින්ම උපකාරී විය. ටේලර් ස්විෆ්ට් යනු ලොව වැඩියෙන්ම ලිංගික කාක්කන්ගේ ගොදුරක් බවට පත්වන සෙලිබ්රිටි ගණයේ ජීවීන්ගෙන් කෙනෙකි.

සෙලිබ්රිටි ඇත්තෝ අල්ලේ නටවන ඩීප් ෆේක් (deep fake)

මෙම සිදුවීම සිදුවී දෙමසක් ගතවීමට මත්තෙන් ඇයව නැවතත් ඩීප්ෆේක් ජඩයන් අතට හසු විය. එවර ඇයගේ නිර්මාණය වූයේ නිරුවත් ඡායාරූප නොව, ජනාධිපති පුටුවට තරග වැදි ඩොනල්ඩ් ට්රම්ප්ට සහය දක්වන බව පෙන්වන ව්යාජ ඡායාරූපයන්ය. ව්යාජ ලෙස ඉන් එක් ඡායාරූපයක් සකසා තිබුණේ ඇය ග්රැමී සම්මාන උළෙලේ රතු පලස මත කැමරාවලට පෙනී සිටිමින් ලබාගත් ඡායාරූපයක් ආශ්රයෙනි. ‘ට්රම්ප් දිනුවා’, ‘ප්රජාතන්ත්රවාදීන් රැවටුණා’ යනුවෙන් ලියැවුණු පුවරුවක් ඇය අතැතිව සිටින අයුරු දැක්වෙන ඇගේ වීඩියෝවක් ද සංස්කරණය කර තිබුණි. බැලූ බැල්මට මේවා සංස්කරණය (Edit) කරන ලද ඡායාරූප හා වීඩියෝ බව සාමාන්ය පුද්ගලයකුට නොතේරෙන්නේ එහි සංස්කරණය කළ බවක් කිසිසේත්ම සොයාගැනීමට ඉඩක් නොමැති නිසාය. එලෙස සැබෑ ලෙසටම පෙනෙන්නට සංස්කරණය කරනා ඡායාරූප, වීඩියෝ ‘ඩීප් ෆේක්’ (deep fake ) යනුවෙන් හඳුන්වන්නේ එනිසාය.

වසර 60කට පසු ප්රථම වතාවට ඇමෙරිකාවේ ලේඛක සංසදය සහ ‘Screen Actors Guild’ (SAG) එක්ව උද්ඝෝෂණයක් හොලිවුඩ් හි පැවැත්විණි. ඒ කෘත්රිම බුද්ධිය (AI) ඔවුන්ගේ වෘත්තීන් තුළට ආක්රමණය වැඩි වීම නිසාය. ඩීප් ෆේක් යනු ෆොටෝෂොප් හෝ වෙනයම් අන්තර්ජාල මෙවලමක් භාවිතයෙන් සැකසුණු වීඩියෝ හෝ ඡායාරූප නොව, කෘතිම බුද්ධි (AI) මෙවලම් භාවිතයෙන් සංස්කරණය කරන ලද හෝ ජනනය කරන ලද සැබෑ නොවන, නොපවතින පුද්ගලයින් සැබෑ ලෙසම නිරූපණය කළ හැකි මාධ්යකින් සැකසුණු ඒවාය. කෘතිම බුද්ධිය නොහොත් AI තාක්ෂණයෙන් පුද්ගලයෙකුගේ හඬක් හා මුහුණේ ලක්ෂණ ගැඹුරු ලෙස අනුකරණය කිරීමේ හැකියාව පවතී. මේවා නිර්මාණය කරන්නේ පවතින සහ නව දර්ශන මිශ්ර කරනා විශේෂිත ඇල්ගොරිදම භාවිත කරමිනි. කෘතිම බුද්ධිය භාවිත කරමින් යම් පුද්ගලයකුගේ මුහුණක්, ශරීරයක් හෝ කට හඬක් හසුරුවමින් වීඩියෝ නිර්මාණය වර්තමානයේ සුලබ කාරණාවක් වී හමාරය. 2023 වසරේ සිදුකරන ලද අධ්යයනයකින් හෙළි වී තිබුණේ කෘතිම බුද්ධිය හේතුවෙන් 2019 සිට ව්යාජ ඡායාරූප හා වීඩියෝ නිර්මාණය කෙරෙහි ලොව පුරා 550%ක වර්ධනයක් සිදු වී ඇති බවකි. ඇසෙනා දේට වඩා කවුරුත් විශ්වාස කරන්නේ දකිනා දේය. එය ලෝක ස්වභාවයයි. නමුත් වර්තමානයේ උදා වී ඇත්තේ අපට ඇසෙනා දේවත් දකිනා දේවත් එකපයින් විශ්වාස කළ නොහැකි කාලයකි. තාක්ෂණය ඇත්තේ මිනිසා අපයෝජනය කිරීමට නොව නමුත් අතීතයේත් වර්තමානයේත් ඇතැම්විට අනාගතයේදීත් කෘතිම බුද්ධිය මිනිස් ජීවිත බිලිගන්නා තැනට වැඩකටයුතු සිද්ධ වුවහොත් ඒ පිළිබඳ අප පුදුම විය යුතු නැත.

මුල්කාලීනව ඩීප් ෆේක් (deep fake) තාක්ෂණය යොදාගනු ලැබුවේ විනෝදය සඳහා හෝ විද්යාත්මක පර්යේෂණ වෙනුවෙනි. එය එක් අවස්ථාවක අතිශය සෞන්දර්යාත්මක වෙළෙඳ දැන්වීමක් වෙනුවෙන් සාර්ථක ලෙස අප ද භාවිත කළෙමු. මෙරට සංගීත ක්ෂේත්රය දිග්විජය කළ එච්. ආර්. ජෝතිපාල, මිල්ටන් මල්ලවආරච්චි, ක්ලැරන්ස් විජේවර්ධන සහ සුනිල් පෙරේරා යන ගායකයින් සිව්දෙනාගේ රුව කෘත්රිම බුද්ධිය ඇසුරින් ප්රතිනිර්මාණය කර නිර්මාණය වූ ජීවිත රක්ෂණ වෙළෙඳ දැන්වීම ඔබට මතක ඇතුවාට සැක නැත. මෙවැනි නිර්මාණශීලී දෑ වෙනුවෙන් භාවිත කළ හැකි ඩීප් ෆේක් තාක්ෂණය පසුකාලීනව හිතාමතාම දේශපාලනඥයන්, ලෝක නායකයන්, ප්රසිද්ධ කලා තරු වැන්නවුන් ඉලක්ක කරගනිමින් මහජනතාව මුලා කිරීම සඳහා යොදාගත්හ. වඳුරන්ට දැළිපිහිය හසු වුණි.

සාවද්ය තොරතුරු සත්ය ආකාරයෙන් පැතිරවීමට ඩීප් ෆේක්ස් භාවිත කිරීම අතිශය භයානක කරුණකි. මෙම තාක්ෂණය මගින් යමෙකුගේ කටහඬේ ශ්රව්ය පටිගත කිරීමක් ඔස්සේ එම පුද්ගලයා කිසිදා නොකියූ දේවල් කියූ ලෙසට සංස්කරණය කිරීමට හැකියාවක් ඇත. යම් පුද්ගලයකුගේ ඡායාරූපයකින් පමණක් ඔහුගේ හෝ ඇයගේ මුහුණේ චලනයන් සියල්ල අනුකරණය කරමින් වීඩියෝ පට සකස් කළ හැකිය. මෙවැනි නිර්මාණ සෑදීමට භාවිත කරනා තාක්ෂණයන් දිනෙන් දින වැඩිදියුණු වීම මේවා සංස්කරණයන් බව තේරුම් ගැනීමට ලෙහෙසියෙන් නොහැකි වීමට හේතුවයි. ඩීප් ෆේක්ස් යනු කෘතිම බුද්ධියේ තවත් එක් ආකාරයකි. එය බොහෝ ප්රයෝජනවත් අයුරින් භාවිත කළ හැකිය. එසේම එය හා ගනුදෙනුව දැළිපිහියෙන් කිරි කනවා වැනි කාරියකි.

වාර්තා නොවුණු සිදුවීම් රැසක් අපේ රටෙත්

වීඩියෝ ඇමතුමක් ලබා දී ඩීප් ෆේක් තාක්ෂණය භාවිත කරමින් මූල්ය සමාගමක ප්රධාන මූල්ය නිලධාරියකු ලෙස පෙනී සිටිමින් එම සමාගමේම මූල්ය සේවකයකු රවටා ඇමෙරිකානු ඩොලර් මිලියන 25කට ආසන්න මුදලක් ලබාගැනීමේ පුවතක් හොංකොං නගරයෙන් කලකට පෙර වාර්තා විය. හොංකොං පොලිසියට අනුව වංචාකරු වීඩියෝ ඇමතුමට සම්බන්ධ වී ඇත්තේ සමාගමේ තවත් සේවකයන් කිහිපදෙනකු සමග පෙනී සිටිමින් වන අතර එම සේවකයන් ද ඩීප්ෆේක් තාක්ෂණය භාවිත කරමින් සැකසූ රූප බව පසුව අනාවරණය වී තිබුණි. පළමුව රහසිගත මුදල් ගනුදෙනුවක් පිළිබඳව පවසමින් ව්යාජ විද්යුත් තැපෑලක් ඔස්සේ පණිවිඩයක් පැමිණීම නිසාවෙන් සේවකයා සැක පළ කළ ද වීඩියෝ ඇමතුම ඔස්සේ තමන් හා සම්බන්ධව ඇත්තේ තම ආයතනයේම සාමාජිකයන් බව පෙනී යෑමෙන් එය විශ්වාස කිරීමට පෙළඹී තිබුණි. මෙම සිදුවීම සිදු වූ චීනය යනු ඩීප් ෆේක් තාක්ෂණය වැඩියෙන්ම අවභාවිත කරනා රටවල්වලින් එකකි. චීනයට ෆේස්බුක් තහනම් වීම පුදුමයක් නොවේ.

සමාජ මාධ්ය භාවිත කරනා සියල්ලන්ම එම සමාජ මාධ්යයේ පාරිභෝගිකයන් බව ෆේස්බුක් නිර්මාණය කළ කණ්ඩායමේ සාමාජිකයින්ගේ අදහස් ඇසුරින් නිර්මාණය කළ Social Dilemma නම් වූ වාර්තා වැඩසටහනේ ඔවුහුම සඳහන් කරති. සමාජ මාධ්ය අපව මෙහෙයවනු ලබයි. සමාජ මාධ්ය තුළ ඇසෙනා දකිනා බොහෝ දේ ඇස් බැන්දුමක් බවද එම වාර්තා වැඩසටහනේම සඳහන් විය. ඩීප්ෆේක් ඊට හොඳම උදාහරණයයි.

කෘතිම බුද්ධිය භාවිත කරමින් මෙවැනි මගඩි සිදුවන්නේ බලපුළුවන්කාර රටවල පමණක් නොවේ. ලංකාවේ ද එවැනි කප්පිත්තෝ එමටය. පසුගිය සතියේ ටෙලිග්රෑම් හරහා ඔන්ලයින් සමූහ කණ්ඩායම් පන්තියකට සහභාගි වූ සිසුවියන්ගේ ඡායාරූප කිහිපයක් බාගත කොට ඒවා කෘතිම බුද්ධි තාක්ෂණය ඔස්සේ නිරුවත් ඡායාරූප ලෙස සංස්කරණය කොට අන්තර්ජාලයට මුදාහළ පුවතක් වාර්තා විය. ඒ පිළිබඳව පරිගණක හදිසි ප්රතිචාර සංසදයෙන් සිසු සිසුවියන්ට අනතුරු ඇඟවීමක් කර තිබුණි. මෙම දැරියන්ගේ සැබෑ ඡායාරූප ඔවුන් සිය ගිණුමට උඩුගත කර තිබුණහොත් ඒවා බාගත කර කෘතිම බුද්ධි තාක්ෂණය ඔස්සේ නිරුවත් ඡායාරූප ලෙස සකස් කර ජාවාරම්කරුවන් අන්තර්ජාලයට මුදාහැර තිබුණි. මේ මිලියන විසි එකක් ජීවත් වන අපේ රටේ වාර්තා වුණු එක් පුවතක් පමණි. වාර්තා නොවන මෙවැනි සිදුවීම් සතියකට සැරයක් සුළු සුළු වශයෙන් හෝ සිදු වනවාට සැක නැත.

ඇතැම් කෘතිම බුද්ධිය සම්බන්ධ නඩුවලදී වින්දිතයෙක් නොමැති විය හැකි බවත් AI ඇසුරෙන් කුඩා දරුවෙකුගේ ඡායාරූපයක් සැකසුවහොත් සමාජ තර්ජනයක් ලෙස ගෙන නීතිය ක්රියාවට නැංවිය හැකි බවත් නියෝජ්ය පොලිස්පතිනි රේණුකා ජයසුන්දර පවසන්නීය. ඇය වැඩිදුරටත් සඳහන් කරන්නේ අසභ්ය දර්ශන, අසභ්ය ප්රකාශන පමණක් නොව තව තව පැතිවලට මේවා අවභාවිත වන නිසාවෙන් කෘතිම බුද්ධි මෙවලම්වලට අදාළව නව නීති පැනවිය යුතු බවය. ශ්රී ලංකා පරිගණක හදිසි ප්රතිචාර සංසදයට අනුව 2023 වසරට සාපේක්ෂව 2024 වසරේ AI ඩීප් ෆේක්ස්වලට අදාළව ලැබුණු පැමිණිලි සංඛ්යාව ඉහළ ගොස් ඇත. 2024 වසරේ ජනවාරි සිට නොවැම්බර් දක්වා පැමිණිලි දළ වශයෙන් 400ක් පමණ ලැබී ඇති බව ද එම සංසදය සඳහන් කරයි.

මේ තාක්ෂණයේ නවීනත්වය සහ එය භාවිත කළ හැකි යහපත් ආකාර මෙන්ම අයහපත් ආකාර පිළිබඳව සියල්ලෝම සැලකිලිමත් විය යුතු කාලයකි. අනාගත ලෝකයේදී මිනිසාගේ පැවැත්ම වෙනුවෙන් විශාල කාර්යභාරයක් ඉටුකිරීමෙහිලා දිනෙන් දින වැඩිදියුණු වන කෘතිම බුද්ධිය කෙදිනක හෝ හිසට පහත් වන හෙණ ගෙඩියක් නොවිය යුතුය. සන්නිවේදනය, සෞඛ්ය, ප්රවාහන කටයුතු, මහජන ආරක්ෂාව වැනි සෑම පැත්තකින්ම මිනිසාගේ සහයට මිනිසා විසින්ම නිර්මාණය කළ කෘතිම බුද්ධිය මිනිසාටම තර්ජනයක් නොවිය යුතුය. කෙසේවෙතත් කෘතිම බුද්ධියේ මෙවලම් බහුල වශයෙන් භාවිත කරන ලෝකයක ඒවා මිනිසාට තර්ජනයක් ලෙස භාවිත කරනා අපරාධකරුවන් හේතුවෙන් මේවාට යම් නිර්නායක, නීති අනිවාර්යයෙන්ම නිර්මාණය විය යුතුය. නැතිනම් අනාගතයේදී අන්තර්ජාල පරිශීලකයන් අන්තර්ජාලයේම සිරකරුවන් වී වින්දිතයෙක් නොමැතිව නඩු අසන්නට වන කාලය වැඩි ඈතක නොවේ.

එරංදි කෞශල්යා මද්දුම